Deepfake Audios in Geschäftsmails

Ihr Chef ruft an. Aber ist er es wirklich?

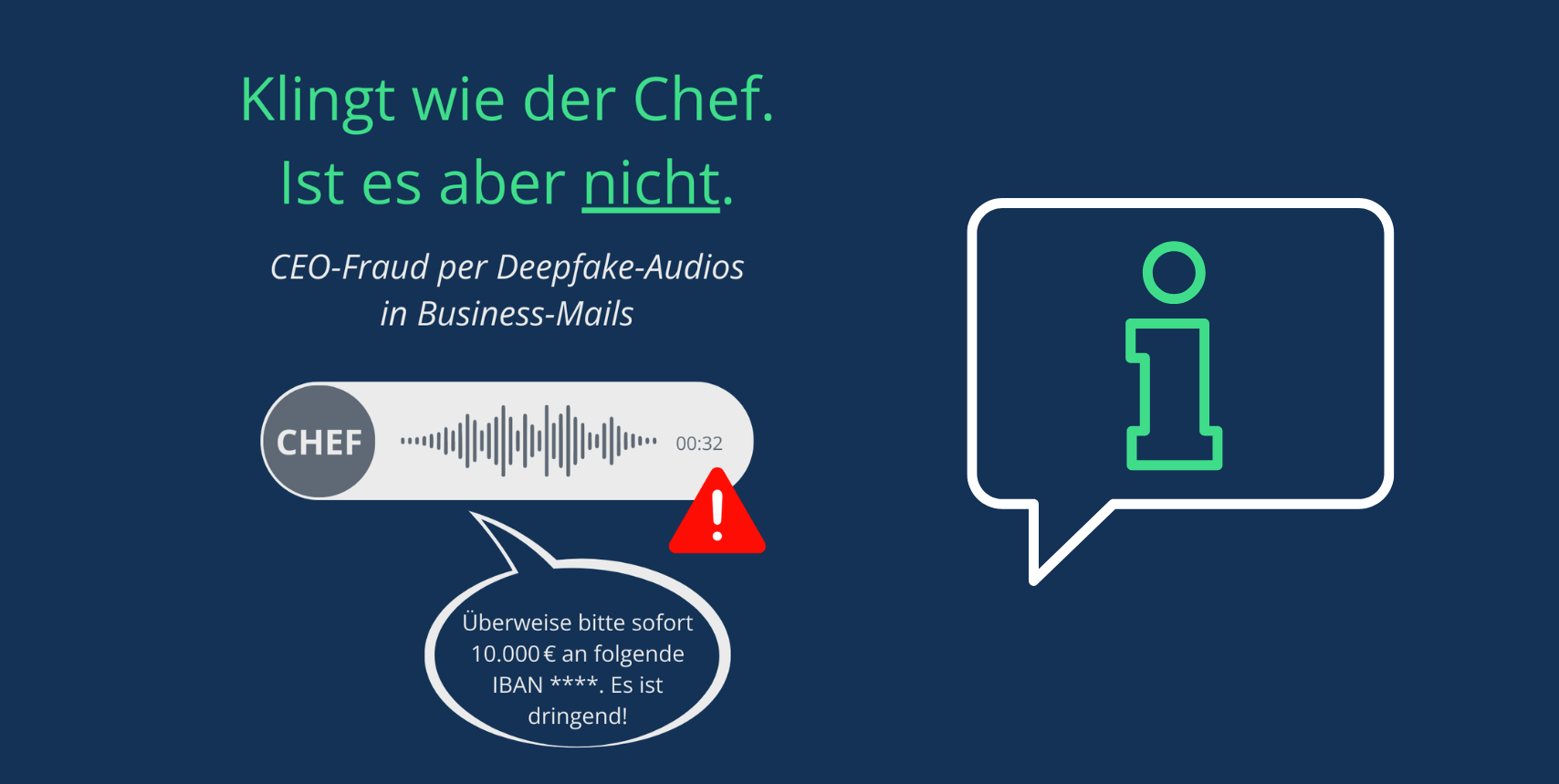

CEO-Fraud erreicht eine neue Qualität: Deepfake-Audios mit täuschend echten Stimmen. Was früher nach Science-Fiction klang, ist 2026 Realität. Cyberkriminelle nutzen öffentlich verfügbare Sprachaufnahmen, z. B. von LinkedIn-Videos oder Podcasts, um mit KI authentisch klingende Sprachnachrichten zu erzeugen.

Das Ziel: Mitarbeitende zu täuschen, Zahlungsanweisungen zu geben oder sensible Informationen zu erschleichen.

i Wie immer gilt: SecuMail®– Kunden können entspannenWir arbeiten kontinuierlich daran, solche Bedrohungen abzufangen. Ihr Wissen über die Tricks der Angreifer macht den Schutz komplett.

So läuft ein typischer Angriff ab:

- Die Stimme der Geschäftsführung wird mit KI imitiert

- Eine dringende Sprachnachricht wird an einen Mitarbeiter geschickt oder ein Mitarbeiter wird angerufen

- Inhalt: „Bitte überweise kurzfristig 10.000 Euro, es ist dringend.“

4 typische Warnsignale bei Deepfake-Audios:

- Schlechte Tonqualität, Störgeräusche, Hintergrundlärm

- Ungewohnte Kommunikationswege

- Zeitdruck und Dringlichkeit ohne Kontext

- Ungewohnt kurze oder inhaltlich diffuse Nachrichten

Was hilft zusätzlich?

- Gegenprüfen auf einem zweiten Kanal

- Rückruf bei der bekannten Nummer

- Und vor allem: Nicht sofort reagieren, sondern bewusst innehalten und prüfen

Unser Fazit:

Deepfake-Angriffe sind kein Zukunftsszenario mehr. Sie erfordern keine technischen Fehler, sondern nutzen psychologische Muster wie Stress, Autorität, Zeitdruck.